Álgebra lineal

Ecuaciones lineales en álgebra lineal

Operaciones elementales de fila

Las operaciones elementales de fila son tres operaciones que se pueden realizar en las filas de una matriz:

- (Reemplazo) Sustituir una fila por la suma de sí misma y un múltiplo de otra fila.

- (Intercambio) Intercambiar dos filas.

- (Escalamiento) Multiplicar todos los elementos de una fila por una constante diferente de cero.

Forma escalonada de una matriz

Una matriz rectangular está en forma escalonada (o forma escalonada por filas) si tiene las siguientes tres propiedades:

- Todas las filas diferentes de cero están arriba de las filas que solo contienen ceros.

- Cada entrada principal de una fila está en una columna a la derecha de la entrada principal de la fila superior.

- En una columna todas las entradas debajo de la entrada principal son ceros.

Si una matriz de forma escalonada satisface las siguientes condiciones adicionales, entonces está en forma escalonada reducida (o forma escalonada reducida por filas):

- La entrada principal en cada fila diferente de cero es .

- Cada entrada principal es la única entrada distinta de cero en su columna.

Por ejemplo, las matrices

están en forma escalonada y forma escalonada reducida, respectivamente.

De forma general, las matrices en forma escalonada pueden tener entradas principales () con cualquier valor diferente de cero, pero las entradas con asterisco () pueden tener cualquier valor, incluyendo cero.

En cambio, las matrices en forma escalonada reducida tienen entradas principales iguales a y hay ceros abajo y arriba de cada entrada principal .

Unicidad de la forma escalonada reducida

Cada matriz es equivalente por filas a una, y solo a una, matriz escalonada reducida.

Si una matriz es equivalente por filas a una matriz escalonada , entonces se llama una forma escalonada (o una forma escalonada por filas) de ; si está en forma escalonada reducida, entonces es la forma escalonada reducida de .

Posiciones pivote

Una posición pivote en una matriz es una ubicación en que corresponde a un principal en la forma escalonada reducida de . Una columna pivote es una columna de que contiene una posición pivote.

En los ejemplos anteriores, los cuadrados () identifican las posiciones pivote.

Algoritmo de reducción por filas

El algoritmo que sigue consta de cuatro pasos y produce una matriz en forma escalonada. Un quinto paso da por resultado una matriz en forma escalonada reducida.

- Se inicia con la columna diferente de cero del extremo izquierdo. Esta es una columna pivote. La posición pivote se ubica en la parte superior.

- Seleccione como pivote una entrada diferente de cero en la columna pivote. Si es necesario, intercambie filas para mover esta entrada a la posición pivote.

- Utilice operaciones de remplazo de filas para crear ceros en todas las posiciones ubicadas debajo del pivote.

- Cubra (o ignore) la fila que contiene la posición pivote y cubra todas las filas, si las hay, por encima de esta. Aplique los pasos 1 a 3 a la submatriz restante. Repita el proceso hasta que no haya filas diferentes de cero por modificar.

- Empezando con la posición pivote del extremo derecho y trabajando hacia arriba y hacia la izquierda, genere ceros arriba de cada pivote. Si un pivote no es 1 , conviértalo en 1 mediante una operación de escalamiento.

La combinación de los pasos 1 a 4 se conoce como fase progresiva del algoritmo de reducción por filas. El paso 5, que produce la única forma escalonada reducida, se conoce como fase regresiva.

Ejemplo: Algoritmo de reducción por filas

Transforme la siguiente matriz a la forma escalonada, y luego a la forma escalonada reducida:

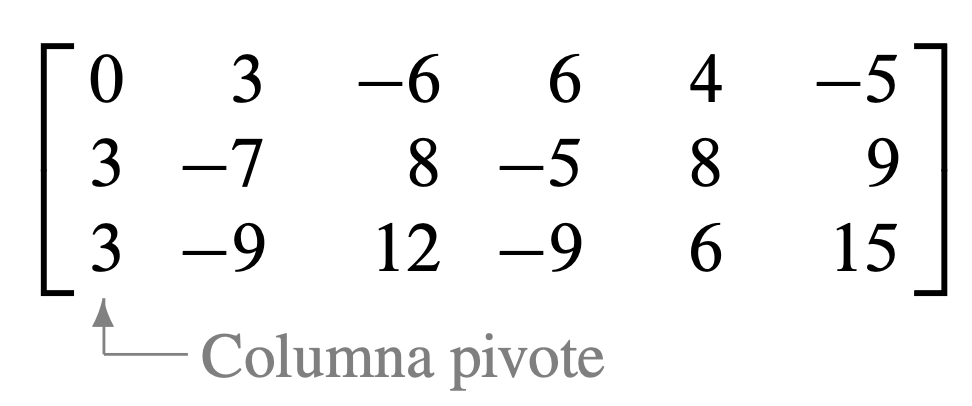

Paso 1: Elegimos el pivote.

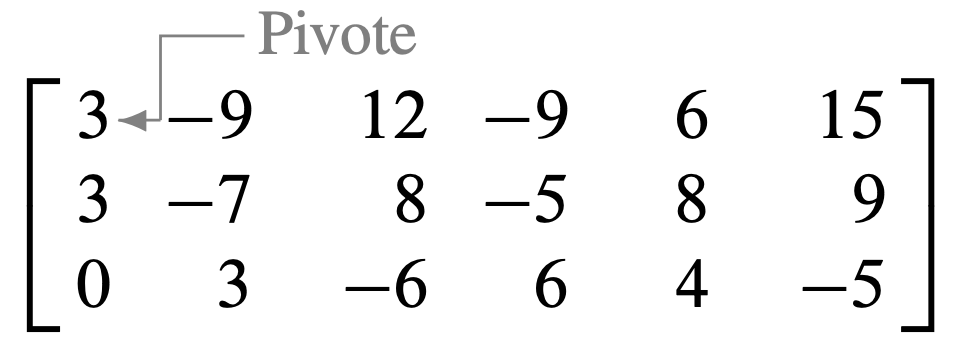

Paso 2: Intercambiamos las filas 1 y 3. (O bien, también se podrían intercambiar las filas 1 y 2).

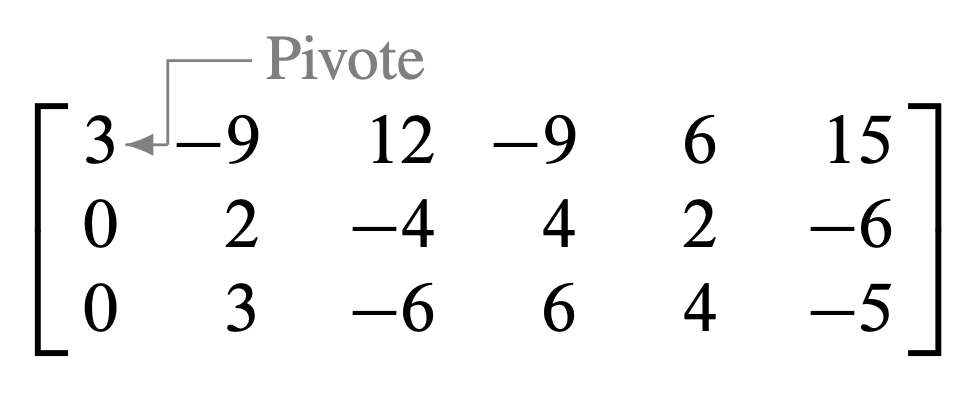

Paso 3: Como paso preliminar, se podría dividir la fila superior entre el pivote, . Pero con dos números en la columna 1, esto es tan fácil como sumar la fila 1 multiplicada por a la fila 2.

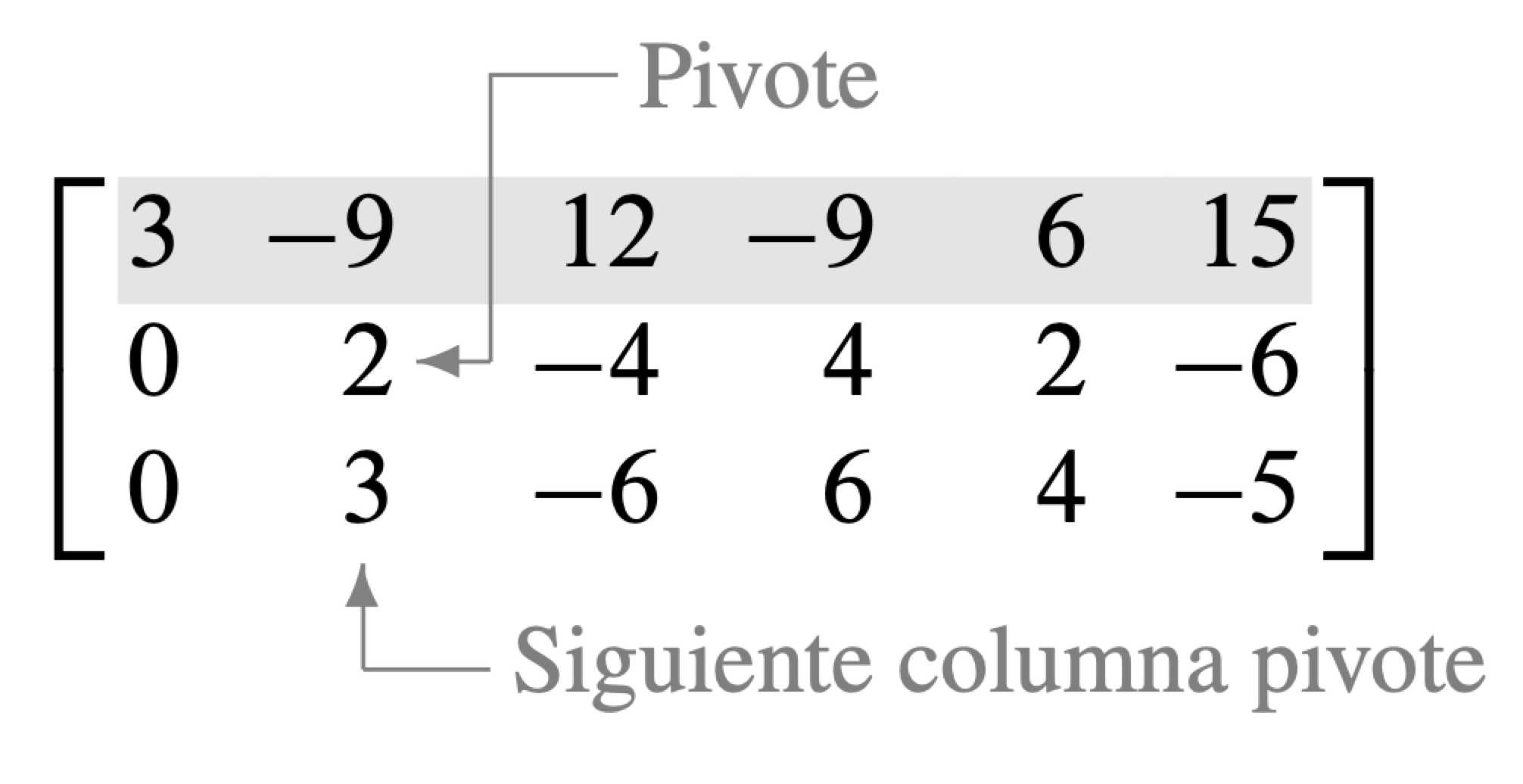

Paso 4: Con la fila 1 cubierta, el paso 1 muestra que la columna 2 es la próxima columna pivote; para el paso 2, seleccione como pivote la entrada "superior" en esa columna.

En el paso 3, se podría insertar un paso adicional de dividir la fila "superior" de la submatriz entre el pivote, . En vez de ello, se suma la fila "superior" multiplicada por a la fila de abajo. Esto produce

Para el paso 4, cuando se cubre la fila que contiene la segunda posición pivote, se obtiene una nueva submatriz con una sola fila:

Los pasos 1 a 3 no necesitan aplicarse para esta submatriz, pues ya se ha alcanzado una forma escalonada para la matriz completa. Si se desea la forma escalonada reducida, se efectúa un paso más.

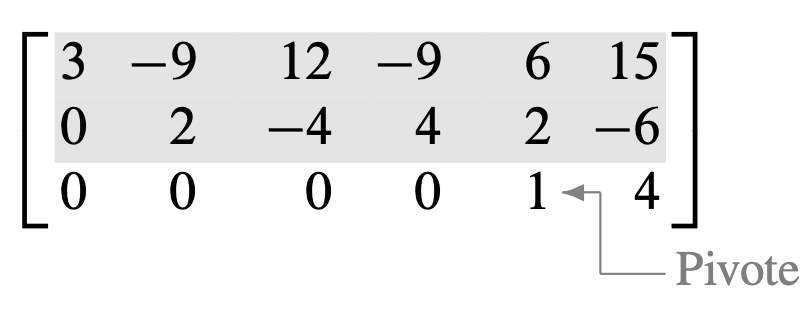

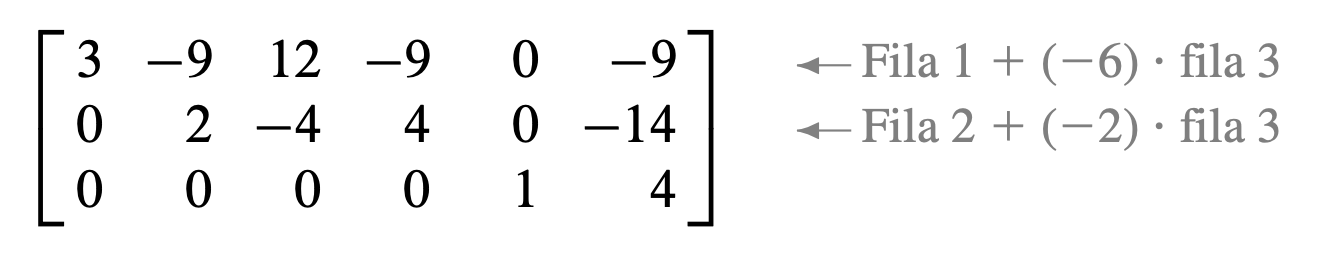

Paso 5: El pivote del extremo derecho está en la fila 3. Genere ceros sobre él, sumando múltiplos adecuados de la fila 3 a las filas 1 y 2.

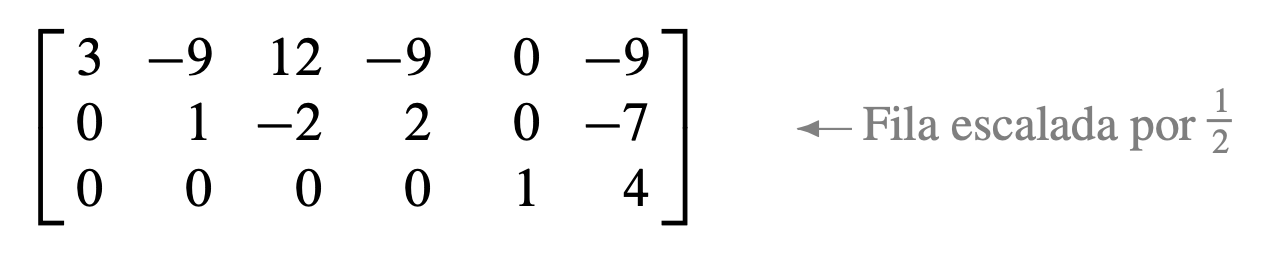

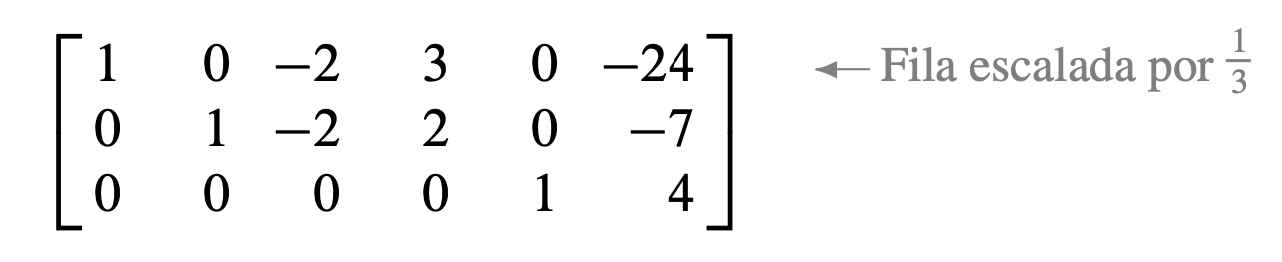

El siguiente pivote se encuentra en la fila 2 . Se escala esta fila dividiéndola entre el pivote.

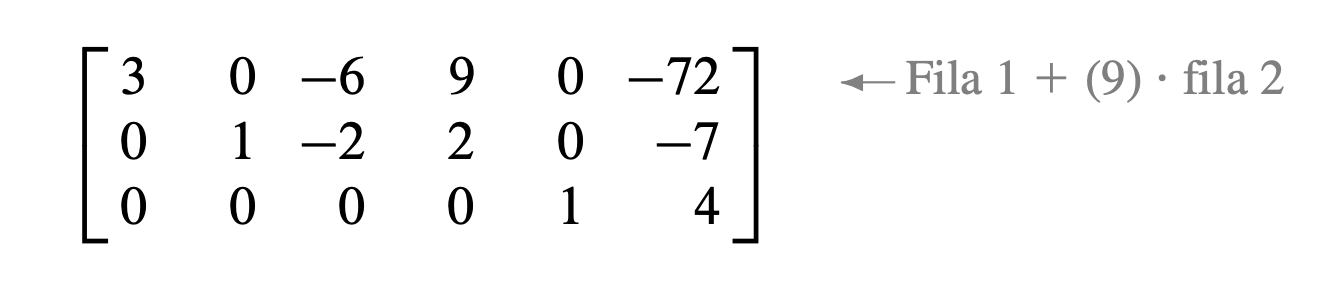

Cree un cero en la columna 2 sumando la fila 2 multiplicada por 9 a la fila 1.

Finalmente, escale la fila 1 dividiéndola entre el pivote, 3.

Esta es la forma escalonada reducida de la matriz original.

Soluciones de sistemas lineales

El algoritmo de reducción por filas conduce directamente a una descripción explícita del conjunto solución de un sistema lineal cuando se aplica a la matriz aumentada del sistema.

Suponga, por ejemplo, que la matriz aumentada de un sistema lineal se transformó a la forma escalonada reducida equivalente

Existen tres variables porque la matriz aumentada tiene cuatro columnas. El sistema de ecuaciones asociado es

Las variables y correspondientes a las columnas pivote se conocen como variables básicas. La otra variable, , se denomina variable libre.

Siempre que un sistema es consistente, como el anterior, el conjunto solución se puede describir explícitamente al despejar en el sistema de ecuaciones reducido las variables básicas en términos de las variables libres. Esta operación es posible porque la forma escalonada reducida coloca a cada variable básica en una y solo una ecuación. En el sistema anterior, despeje de la primera ecuación y de la segunda. (Ignore la tercera ecuación, ya que no ofrece restricciones sobre las variables).

El enunciado " es libre" significa que existe libertad de elegir cualquier valor para . Una vez hecho esto, las fórmulas anteriores determinan los valores de y . Por ejemplo, cuando , la solución es ; cuando , la solución es . Cada asignación diferente de determina una solución (distinta) del sistema, y cada solución del sistema está determinada por una asignación de .

Preguntas de existencia y unicidad

Un sistema lineal es consistente si y solo si la columna más a la derecha de la matriz aumentada no es una columna pivote, es decir, si y solo si una forma escalonada de la matriz aumentada no tiene filas del tipo

Si un sistema lineal es consistente, entonces el conjunto solución contiene: i. una única solución, cuando no existen variables libres, o ii. una infinidad de soluciones, cuando hay al menos una variable libre.

El siguiente procedimiento indica cómo encontrar y describir todas las soluciones de un sistema lineal.

- Escriba la matriz aumentada del sistema.

- Emplee el algoritmo de reducción por filas para obtener una matriz aumentada equivalente en forma escalonada. Determine si el sistema es consistente o no. Si no existe solución, deténgase; en caso contrario, continúe con el siguiente paso.

- Prosiga con la reducción por filas para obtener la forma escalonada reducida.

- Escriba el sistema de ecuaciones correspondiente a la matriz obtenida en el paso 3.

- Rescriba cada ecuación no nula del paso 4 de manera que su única variable básica se exprese en términos de cualquiera de las variables libres que aparecen en la ecuación.

Combinaciones lineales

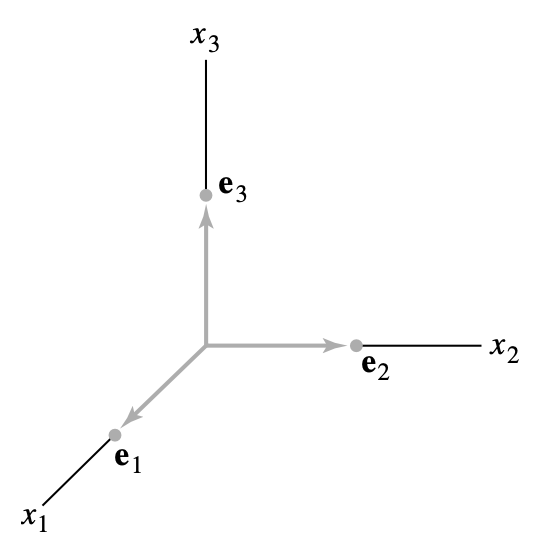

Dados los vectores en y dados los escalares , el vector definido por

se llama combinación lineal de con pesos .

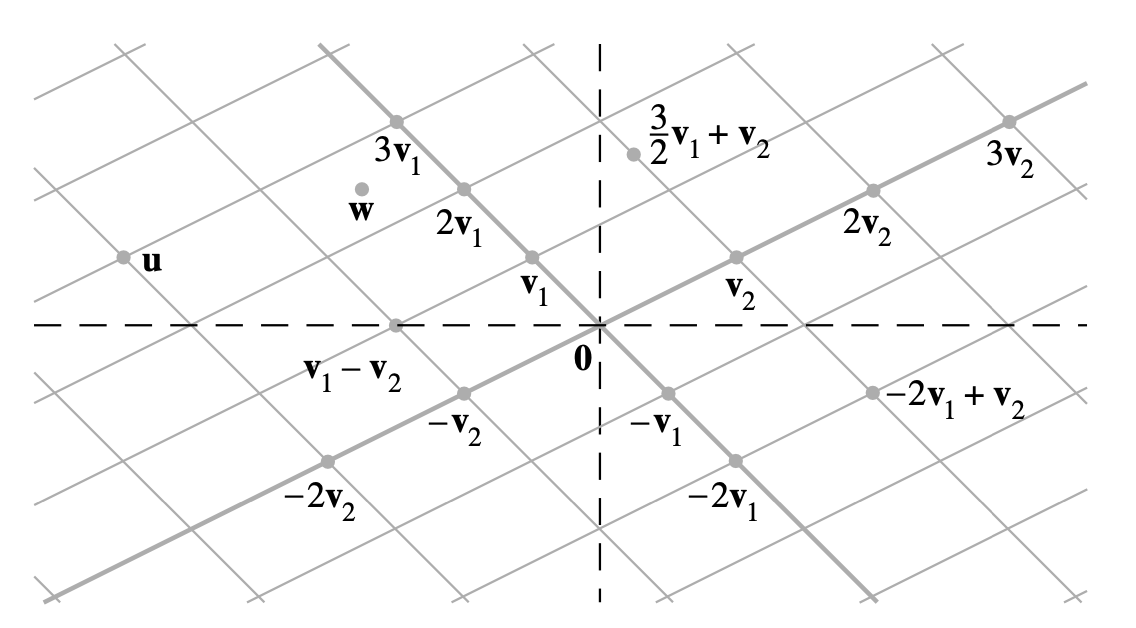

La siguiente figura identifica combinaciones lineales seleccionadas de y .

Espacio generado

Si están en , entonces el conjunto de todas las combinaciones lineales de se denota como y se llama el subconjunto de extendido o generado por . Es decir, es el conjunto de todos los vectores que se pueden escribir en la forma

con escalares .

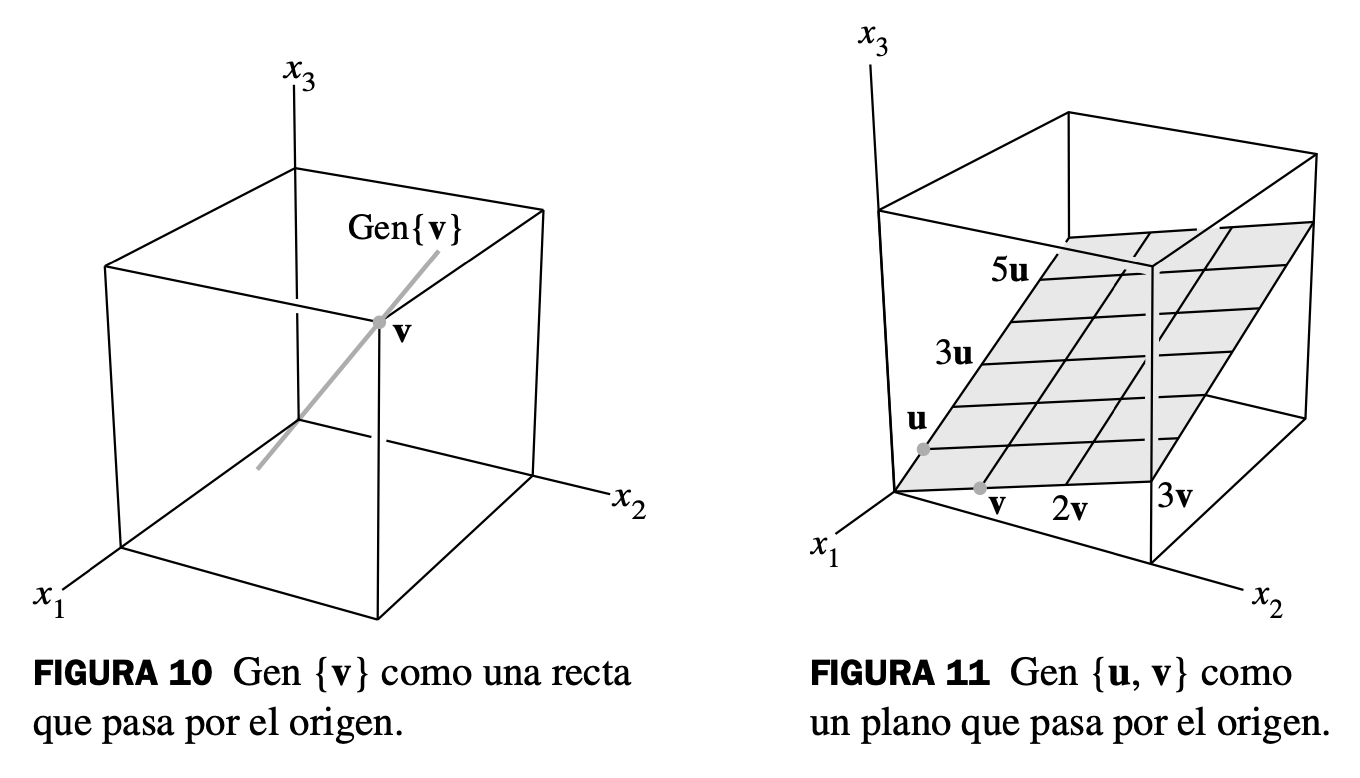

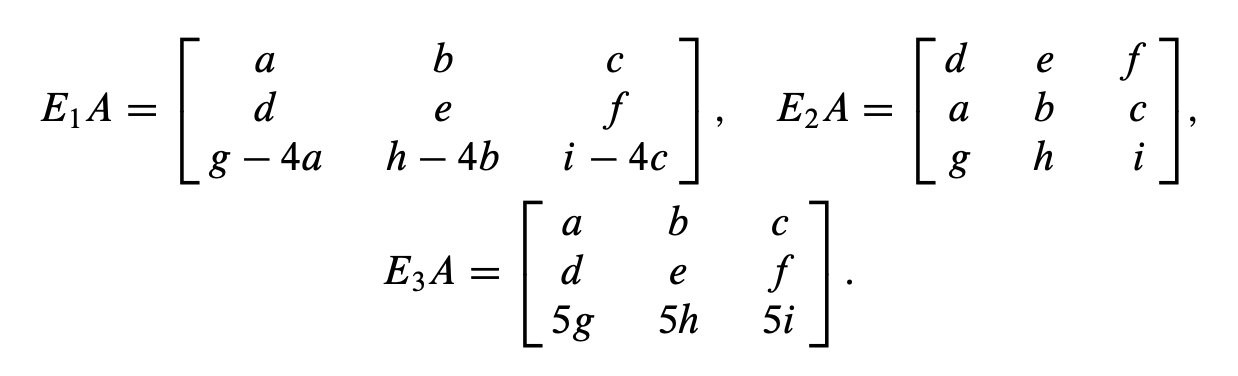

Sea un vector diferente de cero en . Entonces es el conjunto de todos los múltiplos escalares de , que es el conjunto de puntos sobre la recta en que pasa por y .

Si y son vectores diferentes de cero en , y no es un múltiplo de , entonces Gen es el plano en que contiene a y . En particular, Gen contiene la recta en que pasa por y , y la recta que pasa por y .

Ecuación matricial

Si es una matriz de , con columnas , y si está en , entonces el producto de y , denotado como , es la combinación lineal de las columnas de utilizando como pesos las entradas correspondientes en ; es decir,

Si es una matriz de , con columnas , y si está en , la ecuación matricial

tiene el mismo conjunto solución que la ecuación vectorial

la cual, a la vez, tiene el mismo conjunto solución que el sistema de ecuaciones lineales cuya matriz aumentada es

La definición de conduce directamente al siguiente hecho que resulta útil:

La ecuación tiene una solución si y solo si b es una combinación lineal de las columnas de .

Dado lo anterior, podemos enunciar el siguiente teorema:

Sea una matriz de . Entonces, los siguientes enunciados son lógicamente equivalentes. Es decir, para una particular, todos los enunciados son verdaderos o todos son falsos.

- Para cada en , la ecuación tiene una solución.

- Cada en es una combinación lineal de las columnas de .

- Las columnas de generan .

- tiene una posición pivote en cada fila.

Sistemas lineales homogéneos

Se dice que un sistema de ecuaciones lineales es homogéneo si se puede escribir en la forma , donde es una matriz de , y es el vector cero en . Tal sistema siempre tiene al menos una solución, a saber, (el vector cero en ). Esta solución cero generalmente se conoce como solución trivial. Para una ecuación dada , la pregunta importante es si existe una solución no trivial, es decir, un vector diferente de cero que satisfaga . El teorema de existencia y unicidad conduce de inmediato al siguiente resultado.

La ecuación homogénea tiene una solución no trivial si y solo si la ecuación tiene al menos una variable libre.

Independencia lineal

Las ecuaciones homogéneas se pueden estudiar desde una perspectiva diferente si las escribimos como ecuaciones vectoriales. De esta manera, la atención se transfiere de las soluciones desconocidas de a los vectores que aparecen en las ecuaciones vectoriales.

Por ejemplo, considere la ecuación

Esta ecuación tiene una solución trivial, desde luego, donde . Al igual que hemos discutido antes, el asunto principal es si la solución trivial es la única.

Se dice que un conjunto indexado de vectores en es linealmente independiente si la ecuación vectorial

solo tiene la solución trivial.

Se dice que el conjunto es linealmente dependiente si existen pesos , no todos cero, tales que

La ecuación que define el concepto de "linealmente dependiente" se llama relación de dependencia lineal entre cuando no todos los pesos son cero. Un conjunto indexado es linealmente dependiente si y solo si no es linealmente independiente. Por brevedad, puede decirse que son linealmente dependientes cuando queremos decir que es un conjunto linealmente dependiente. Se utiliza una terminología semejante para los conjuntos linealmente independientes.

Independencia lineal en columnas de una matriz

Suponga que, en vez de utilizar un conjunto de vectores, se inicia con una matriz . En tal caso, la ecuación matricial se puede escribir como

Cada relación de dependencia lineal entre las columnas de A corresponde a una solución no trivial de . Así, tenemos el siguiente resultado importante.

Las columnas de una matriz son linealmente independientes si y solo si la ecuación tiene solo la solución trivial.

Geometría de la dependencia lineal

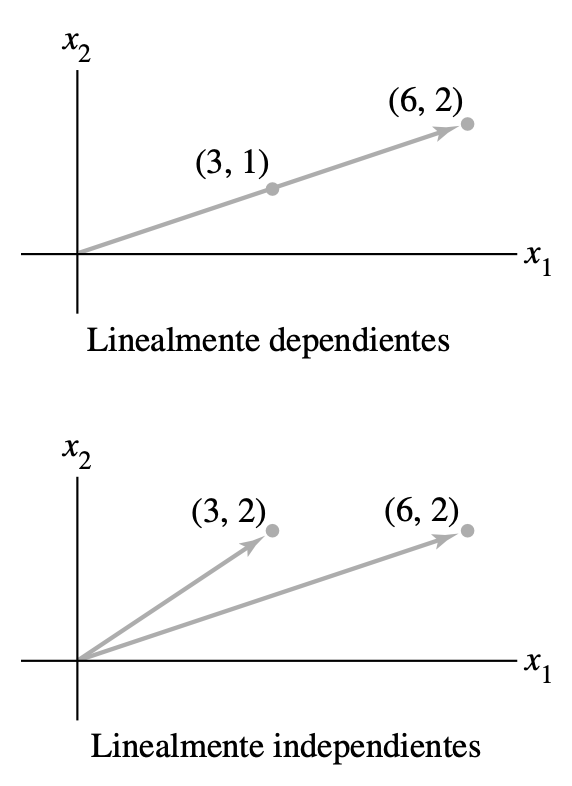

Siempre es posible determinar por inspección cuándo un conjunto de dos vectores es linealmente dependiente. Las operaciones de fila son innecesarias. Basta con comprobar si al menos uno de los vectores es un escalar multiplicado por el otro. (La prueba solo se aplica a conjuntos de dos vectores).

Un conjunto de dos vectores es linealmente dependiente si al menos uno de los vectores es un múltiplo del otro. El conjunto es linealmente independiente si y solo si ninguno de los vectores es un múltiplo del otro.

En términos geométricos, dos vectores son linealmente dependientes si y solo si ambos están sobre la misma recta que pasa por el origen.

Para dos o más vectores, tenemos el siguiente resultado:

Un conjunto indexado de dos o más vectores es linealmente dependiente si y solo si al menos uno de los vectores en es una combinación lineal de los otros. De hecho, si es linealmente dependiente y , entonces alguna ) es una combinación lineal de los vectores precedentes, .

Los siguientes dos teoremas describen casos especiales en los cuales la dependencia lineal de un conjunto es automática.

Si un conjunto contiene más vectores que entradas en cada vector, entonces el conjunto es linealmente dependiente. Es decir, cualquier conjunto en es linealmente dependiente si .

Si un conjunto en contiene al vector cero, entonces el conjunto es linealmente dependiente.

Transformaciones lineales

La correspondencia de a es una función de un conjunto de vectores a otro. Este concepto generaliza la noción común de una función como una regla que transforma un número real en otro.

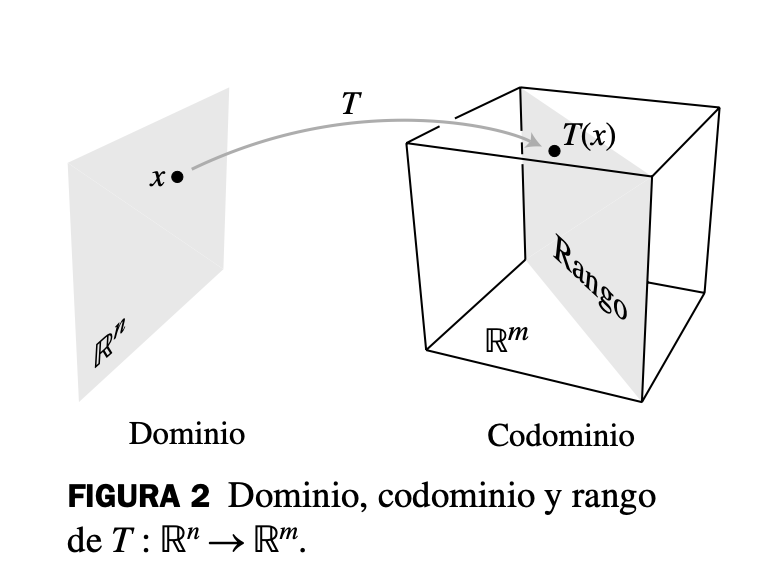

Una transformación (o función o mapeo) de a es una regla que asigna a cada vector en un vector en . El conjunto se llama el dominio de , y se llama el codominio de . La notación indica que el dominio de es y que el codominio es . Para en , el vector en es la imagen de (bajo la acción de ). El conjunto de todas las imágenes es el rango de .

Para cada en se calcula como , donde es una matriz de . Para simplificar, algunas veces esta transformación matricial se denota como . Observe que el dominio de es cuando tiene columnas, y el codominio de es cuando cada columna de tiene entradas. El rango de es el conjunto de todas las combinaciones lineales de las columnas de , porque cada imagen es de la forma .

Una transformación (o mapeo) es lineal si:

- para todas las , en el dominio de ;

- para todos los escalares y para todas las en el dominio de .

Álgebra de matrices

Operaciones básicas

Sean y matrices del mismo tamaño, y sean y escalares.

Multiplicación de matrices

Si es una matriz de , y si es una matriz de con columnas entonces el producto es la matriz de cuyas columnas son . Es decir,

Es decir, cada columna de es una combinación lineal de las columnas de usando pesos de la columna correspondiente de .

Si el producto está definido, entonces la entrada en la fila y la columna de es la suma de los productos de las entradas correspondientes de la fila de y la columna de . Si denota la entrada en , y si es una matriz de , entonces

Sea una matriz de , y sean y matrices con tamaños para los que las sumas y los productos indicados están definidos.

- para cualquier escalar

- En general, .

- Las leyes de la cancelación no se aplican en la multiplicación de matrices. Es decir, si , en general no es cierto que .

- Si un producto es la matriz cero, en general, no se puede concluir que o .

La transpuesta de una matriz

Dada una matriz de , la transpuesta de es la matriz de , que se denota con , cuyas columnas se forman a partir de las filas correspondientes de .

Sean y matrices cuyos tamaños son adecuados para las siguientes sumas y productos.

- Para cualquier escalar

Inversa de una matriz

Se dice que una matriz de es invertible si existe otra matriz de tal que

donde , la matriz identidad de . En este caso, es una inversa de .

Sea . Si , entonces es invertible y

Si , entonces no es invertible.

La definición de matriz inversa nos entrega el siguiente teorema:

Si es una matriz invertible de , entonces, para cada en , la ecuación tiene la solución única .

Además, podemos definir las siguientes propiedades para matrices invertibles:

- Si es una matriz invertible, entonces es invertible y

- Si y son matrices invertibles de , entonces también lo es , y la inversa de es el producto de las inversas de y en el orden opuesto. Es decir,

- Si es una matriz invertible, también lo es , y la inversa de es la transpuesta de . Es decir,

Matrices elementales

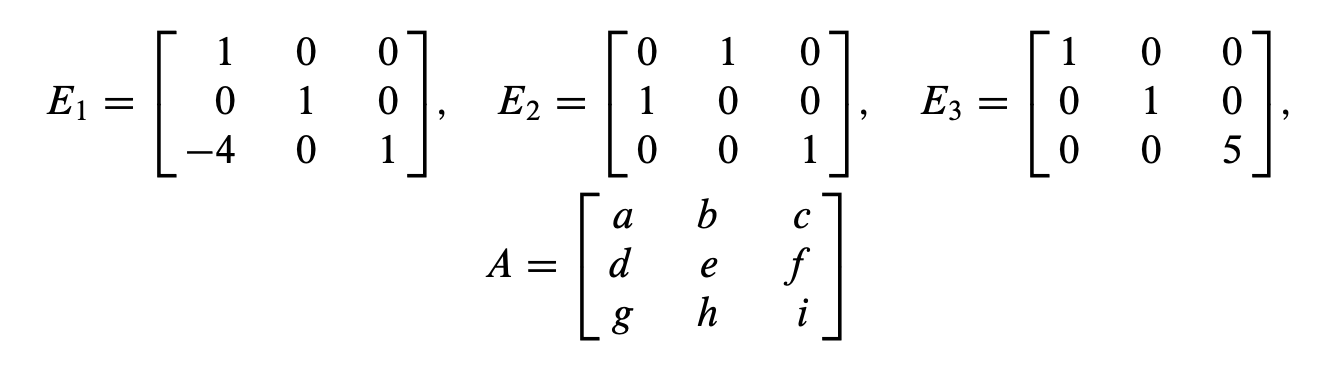

Una matriz elemental es aquella que se obtiene al realizar una única operación elemental de fila sobre una matriz identidad. El siguiente ejemplo ilustra los tres tipos de matrices elementales.

Si se realiza una operación elemental de fila con una matriz de , la matriz resultante se puede escribir como , donde la matriz de se crea al realizar la misma operación de fila sobre .

Por ejemplo, si

entonces

Al sumar a la fila 3 la fila 1 de multiplicada por , se obtiene . (Esta es una operación de remplazo de filas). Con un intercambio de las filas 1 y 2 de se obtiene , y multiplicando la fila 3 de por se obtiene .

Toda matriz elemental es invertible. La inversa de es la matriz elemental del mismo tipo que transforma a de nuevo en .

Una matriz de es invertible si y solo si es equivalente por filas a , y, en este caso, cualquier secuencia de operaciones elementales de fila que reduzca a también transforma a en .

El teorema anterior nos da el siguiente algoritmo para determinar la inversa de una matriz de :

Reduzca por filas la matriz aumentada . Si es equivalente por filas a , entonces es equivalente por filas a . De otra manera, no tiene inversa.

El teorema de la matriz invertible

El resultado principal de todo el estudio anterior es el siguiente teorema.

Sea una matriz cuadrada de . Entonces, los siguientes enunciados son equivalentes. Es decir, para una dada, los enunciados son todos ciertos o todos falsos.

- es una matriz invertible.

- es equivalente por filas a la matriz identidad de .

- tiene posiciones pivote.

- La ecuación tiene solamente la solución trivial.

- Las columnas de forman un conjunto linealmente independiente.

- La transformación lineal es uno a uno.

- La ecuación tiene al menos una solución para toda en .

- Las columnas de generan .

- La transformación lineal mapea sobre .

- Existe una matriz de tal que ,

- Existe una matriz de tal que .

- es una matriz invertible.

Transformación lineal invertible

Se dice que una transformación lineal es invertible si existe una función tal que

El siguiente teorema establece que si dicha existe, es única y debe ser una transformación lineal. Se dice que es la inversa de y se escribe como .

Sea una transformación lineal y sea la matriz estándar para . Así, es invertible si y solo si es una matriz invertible. En tal caso, la transformación lineal dada por es la única función que satisface las ecuaciones mostradas.

Subespacios

Un subespacio de es cualquier conjunto en que tenga tres propiedades:

- El vector cero está en .

- Para cada y en , la suma está en .

- Para cada en y cada escalar , el vector está en .

Dicho con palabras, un subespacio es cerrado bajo la suma y la multiplicación escalar.

Espacio de columnas

Los subespacios de generalmente se presentan en aplicaciones y en la teoría en una de dos formas. En ambos casos, es posible relacionar el subespacio con una matriz.

El espacio de columnas de una matriz es el conjunto de todas las combinaciones de las columnas de .

Si , con las columnas en , entonces es lo mismo que . De hecho, el espacio columna de una matriz de es un subespacio de . Observe que es igual a solo cuando las columnas de generan a . Si no la generan, es solo una parte de .

Cuando un sistema de ecuaciones lineales está escrito en la forma , el espacio columna de es el conjunto de todas las para las que el sistema tiene una solución.

Espacio nulo

El espacio nulo de una matriz es el conjunto de todas las soluciones posibles para la ecuación homogénea .

Cuando tiene columnas, las soluciones de pertenecen a , y el espacio nulo de es un subconjunto de . De hecho, Nul tiene las propiedades de un subespacio de matrices de .

El espacio nulo de una matriz de es un subespacio de . De manera equivalente, el conjunto de todas las soluciones posibles para un sistema de ecuaciones lineales homogéneas con incógnitas es un subespacio de .

Base para un subespacio

Como, por lo general, un subespacio contiene un número infinito de vectores, algunos problemas relacionados con subespacios se manejan mejor trabajando con un conjunto finito y pequeño de vectores que genere el subespacio. Cuanto menor sea el conjunto, será mejor. Es factible demostrar que el conjunto generador más pequeño posible debe ser linealmente independiente.

Una base de un subespacio de es un conjunto linealmente independiente en , que genera a .

Solo son 4 preguntas de Lineal, después me sigo pegando el show terminando esto 😢